Компьютерный кластер

Краткое описание

Кластер вычислительной системы состоит из физических серверов. Дополнен удаленной облачной инфраструктурой, построен по принципу высокой доступности и отказоустойчивости. Эта архитектура удовлетворяет техническим потребностям и масштабируется как вертикально, так и горизонтально.

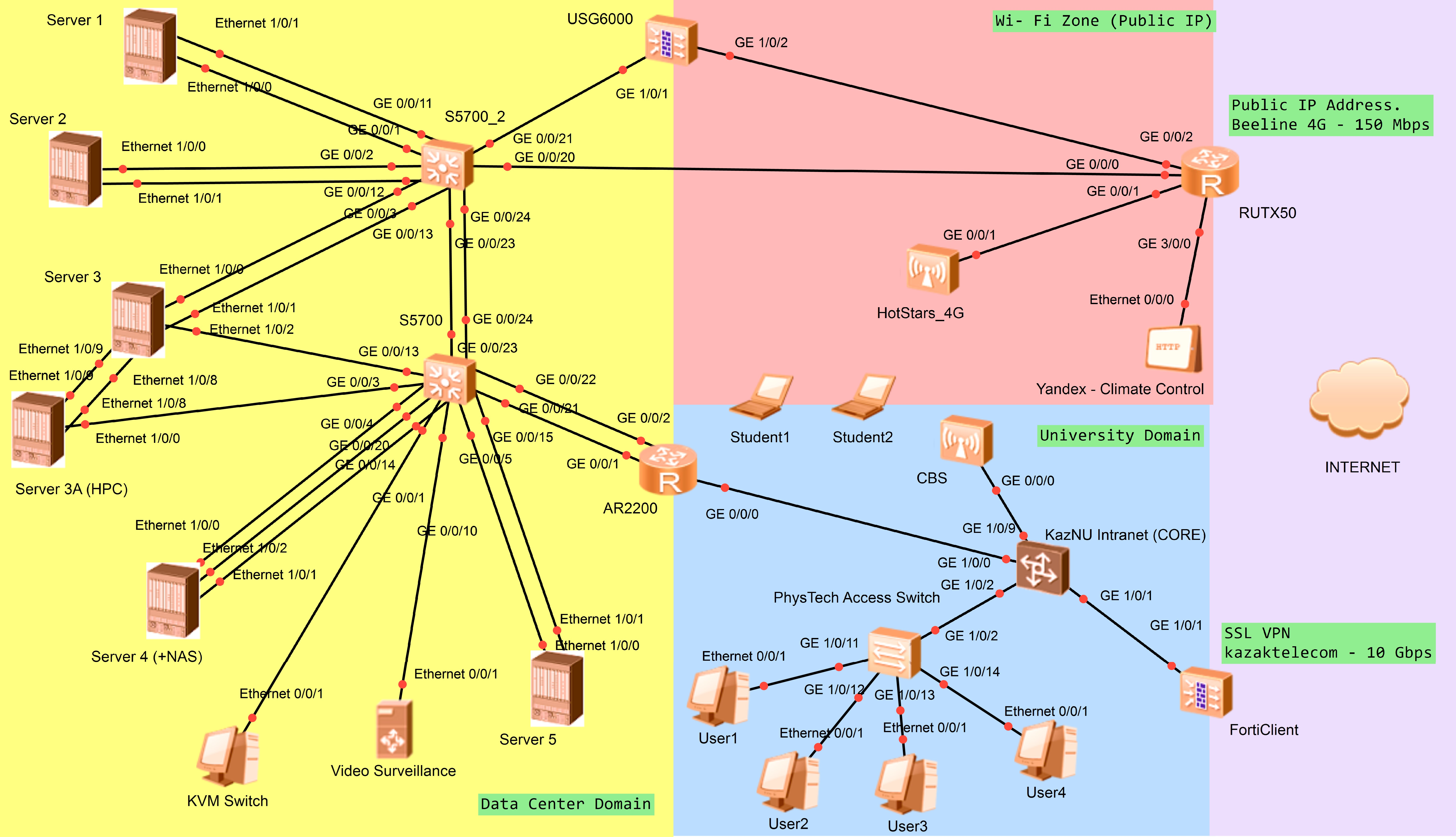

Гибкость и модульность структуры кластера обеспечиваются единой системой управления через распределенные системы электропитания и доступа. Таким образом, достигается полная функциональность вычислительных узлов 24/7, резервное копирование, миграция, хранение данных и доступ с возможностью "горячей" замены и развертывания как отдельных систем, так и целых узлов. Система доступа организована через основной канал со скоростью 1 Гбит/с с использованием защищенной топологии SSL VPN. Резервный радиоканал 4G со скоростью 50 Мбит/с подключен через Firewall с внешним публичным IP-адресом. Облачная часть развернута на арендуемом виртуальном хостинге (Microsoft OneDrive) для поддержки распределения данных и обеспечения доступа. Вычислительный узел представляет собой набор виртуальных машин на общей платформе гипервизора (в частности, HYPER-V, в некоторых случаях ESXi), построенный на общих ресурсах, распределенных между физическими серверами (процессоры Xeon, оперативная память и жесткие диски в массиве RAID).

Электропитание обеспечивается независимыми источниками питания и системой резервного копирования. Система управления питанием поддерживает функцию удаленного доступа. Соединение между машинами внутри домена осуществляется через интерфейсы 10 Гбит/с. Сетевая инфраструктура построена посредством агрегации каналов и резервирования соединений. VLAN-домены транслируют управление системой питания с датчиками мониторинга, управленческой подсетью и подсетью доступа.

Мы используем собственный скрипт на основе Linux-shell для распараллеливания вычислений.

Аппаратное обеспечение кластера состоит из 6 Серверных платформ Enterprise DL380 Gen10 / Gen10 Plus units

Доступные Серверы

| Server | Processor | Comp. resource | Memory | Storage | Management /24 and Access IP |

|---|---|---|---|---|---|

| S1 | Gen10+ 2 x Xeon Gold 6330 |

2.00 GHz, 56 cores / 112 threads |

4 x 32 Gb DDR4-2933 |

3 x 960Gb 2.62 Tb |

192.168.1.71 192.168.0.71 |

| S2 | Gen10+ 2 x Xeon Gold 6348 |

2.60 GHz, 56 cores / 112 threads |

8 x 32 Gb DDR4-3200 |

8 x 960Gb 3.49 Tb (RAID 60) |

192.168.1.72 192.168.0.72 |

| S3 | Gen10 2 x Xeon Gold 6248R |

3.00 GHz, 48 cores / 96 threads |

4 x 32 Gb DDR4-2933 |

480 + 1.92 + 2 x 960 |

192.168.1.73 192.168.1.173 192.168.0.73 |

| S3a | Gen10 2 x Xeon Gold 6248R |

3.00 GHz, 48 cores / 96 threads |

4 x 32 Gb DDR4-2933 |

2 x 960 Gb | 192.168.1.77 192.168.0.77 |

| S4 | Gen10 2 x Xeon Gold 5218R |

2.10 GHz, 40 cores / 80 threads |

2 x 32 Gb DDR4-2666 |

3 x 480 + 4 x 960 Gb |

192.168.1.74 192.168.1.174 192.168.0.74 |

| S5 | Gen10 1 x Xeon Platinum 8180 |

2.50 GHz, 28 cores / 56 threads |

2 x 32 Gb DDR4-2666 |

1 x 960 Gb | 192.168.1.75 192.168.0.75 |

Виртуальные машины

| Server | Виртуальные машины | Comp. Resources CPU / Memory / Storage |

IP Address and Network Capability |

External and Internal NAT ports |

|---|---|---|---|---|

| S1 | Ubuntu18_MHD | 8 th./ 6-8 Gb / 420 Gb | 192.168.0.211 / 10 Gbit/s (shared) |

-- -- |

| Ubuntu18_CVLab | 8 th. / 108 Gb / 127 Gb | 192.168.0.212 / 10 Gbit/s (shared) |

22212 (SSH) -- |

|

| Ubuntu22_MESA | 96 th. / 4-8 Gb / 228 Gb | 192.168.0.213 / 10 Gbit/s (shared) |

-- 33813 (RDP) / 22213 (SSH) |

|

| S2 | Ubuntu18_SPH | 8 th. / 16 Gb / 320 Gb | 192.168.0.221 / 10 Gbit/s (shared) |

-- 33811 (RDP) |

| Ubuntu18_Hdust | 104 th. / 224 Gb / 420 Gb | 192.168.0.222 / 10 Gbit/s (shared) |

8440 (SSH) -- |

|

| S3 | Ubuntu18_SLURM_M | 8 th. / 16 Gb / 320 Gb | 192.168.0.231 / 40 Gbit/s (direct) |

-- -- |

| Ubuntu18_LVCL | 40 th. / 60 Gb / 0.8+1.7 Tb | 192.168.0.232 / 1 Gbit/s (shared) |

3399 (RDP) -- |

|

| Ubuntu18_Phantom | 56 th. / 56 Gb / 228 Gb | 192.168.0.233 / 1 Gbit/s (shared) |

-- 33833 (RDP) / 22233 (SSH) |

|

| S3a | Ubuntu18_SLURM_C | 112 th. / 128 Gb / 228 Gb | 192.168.0.237 / 40 Gbit/s (direct) |

-- -- |

| S4 | Ubuntu16_IRAFv2.16 | 16 th. / 8 Gb / 420 Gb | 192.168.0.241 / 1 Gbit/s (shared) |

-- -- |

| Ubuntu18_IRAFv2.18 | 16 th. / 8 Gb / 420 Gb | 192.168.0.242 / 1 Gbit/s (shared) |

-- -- |

|

| Ubuntu18_Students | 16 th. / 16 Gb / 920 Gb | 192.168.0.243 / 1 Gbit/s (shared) |

-- -- |

|

| Ubuntu22_2024_v1 | 16 th. / 8 Gb / 240 Gb | 192.168.0.244 / 1 Gbit/s (shared) |

-- 33844 (RDP) / 22244 (SSH) |

|

| Windows11_RDP | 8 th. / 8 Gb / 240 Gb | 192.168.0.249 / 1 Gbit/s (shared) |

8391 (RDP) -- |

|

| Windows10_OneDrive | 8 th. / 16 Gb / 1.7 Tb | 192.168.0.200 / 1 Gbit/s (shared) |

8442 (RDP) -- |

|

| S5 | Windows11_TensorFlow | 56 th. / 64 Gb / 960 Gb + 2 Tb SATA / GPU Nvidia A2 |

192.168.0.251 / 1 Gbit/s (direct) |

-- -- |

HP Enterprise ProLiant DL380 Gen10 Plus (support PCIe 4.0), 2U Rack

- Processor:112 threads 2.60 GHz, (max. 3.5 GHz) 2x Intel Xeon Gold 6330, 42M Cache, 28 cores, 56 threads each.

- GPU: 1xNvidia A2

- RAM: 128 GB, 4x32GB, DDR4-3200MHz.

- Storage: 2.8 TB, 3x960GB SSD on 8xSFF bay with MR416i-p NVMe/SAS 12G hardware RAID controller.

- Network: 2x10GE (SFP+, DAC, access), 1x1GE (management).

- Power supply: 1x1600W and 1x800W (backup power).

Вычислительные ресурсы

В общей сложности доступны следующие ресурсы:- 464 потока с тактовой частотой 2.6 ГГц (на 10 физических процессорах серии Xeon Gold 62xx/63xx).

- 1 графический процессор (Nvidia A2)

- 576 ГБ оперативной памяти (DDR4, 2666 MHz)

- 23 ТБ хранилища (SSD / SAS диски в аппаратном массиве RAID).

- Аппаратное обеспечение кластера включает 4 сервера HP Enterprise DL380 Gen10 / Gen10 Plus.

Возможности доступа

- SSH и RDP (VNC по запросу) через публичный IP-адрес.

- Доступ к "пользовательским данным" возможен через Microsoft Сloud (1 ТБ, файловый хостинг) с использованием общих ссылок.

Топология программного и аппаратного обеспечения

- Основная операционная система: Linux (Ubuntu 18.04 LTS).

- Виртуализация: Hyper-V Server 2019.

- Интерфейс интернет-подключения (основной uplink, доступ к локальной сети): 1 Gigabit Ethernet (1 Гбит/с, пинг 2–5 мс, скорость 750 Мбит/с по данным сервиса speedtest.net).

- Резервная сеть 4G, скорость 50 Мбит/с, также используется для доступа по публичному IP.

- Основное энергопитание: 6.5 кВт, резервное питание: 2.2 кВт.

- Взаимодействие внутри кластера: 10GBASE (SFP+, DAC).

- Управляющая сеть VLAN на основе интерфейсов 1 Гбит/с с удаленным доступом через FortiGate SSL VPN.

- Реализованы функции NGFW (многофункциональные межсетевые экраны), инструменты мониторинга системы, маршрутизация и коммутация, включая агрегирование каналов и резервирование соединений.

- Возможность масштабирования как вертикального, так и горизонтального.

- Контрольные точки рабочих нагрузок ОС.

- Резервное копирование и миграция ОС.

- Клонирование и создание образов с текущими конфигурациями и встроенными приложениями.

- Быстрое развертывание ОС и вычислительных узлов.

- Горячая замена аппаратных компонентов серверов в составе кластера.

Особенности эксплуатации и обслуживания (O&M)